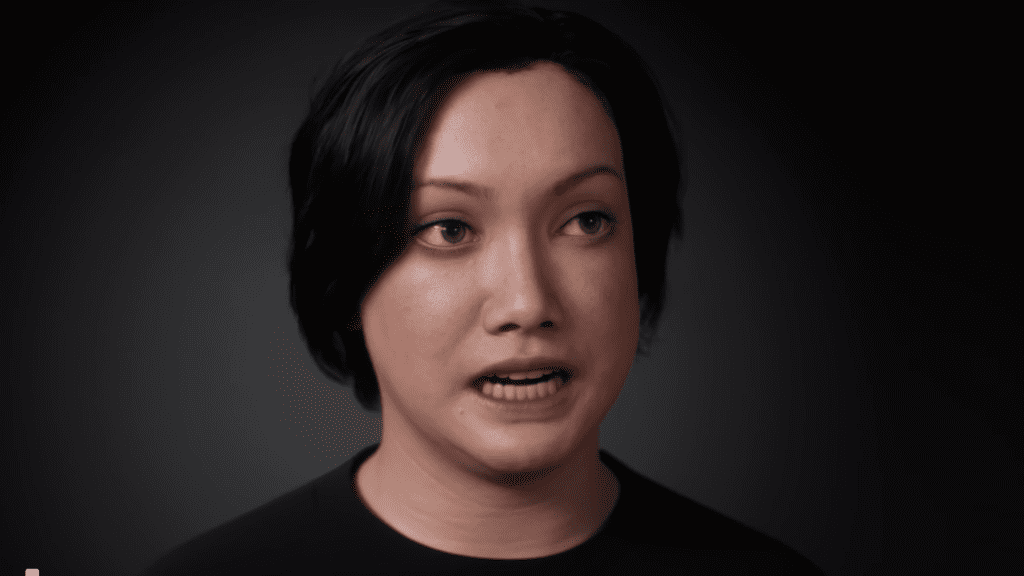

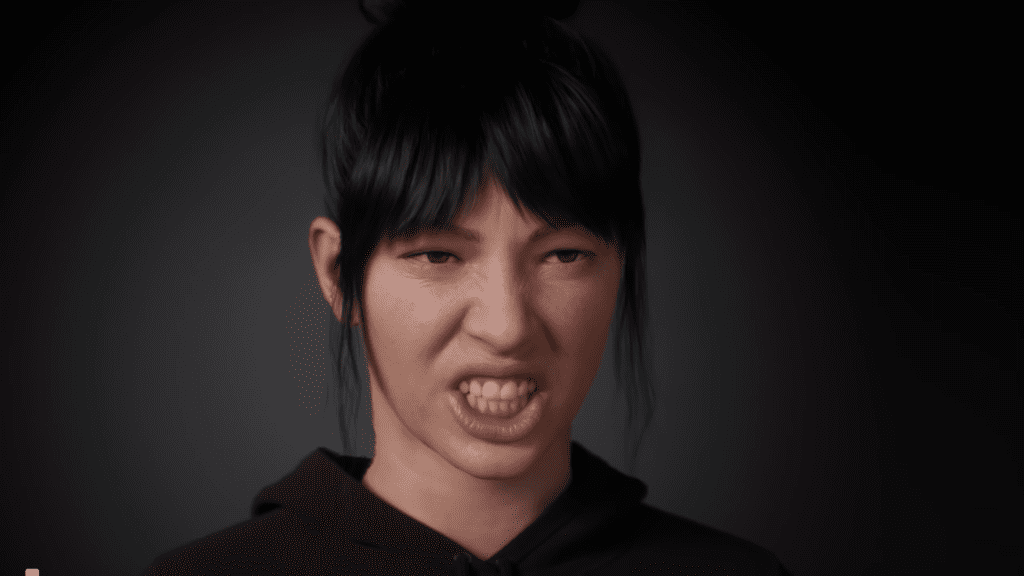

MetaHuman Animator, la nueva función que está por ser lanzada, es una excelente noticia para los creadores de videojuegos y productores de contenido en general. Esta función permite capturar los movimientos faciales de alta fidelidad de un actor utilizando una cámara frontal estéreo, lo que permite transferir los detalles y matices a cualquier personaje de MetaHuman para darle vida en Unreal Engine.

El realismo y la fidelidad son fundamentales para lograr que los humanos digitales sean creíbles, pero esto puede ser muy complicado, incluso para los creadores más experimentados. Es muy difícil que las soluciones de captura de movimiento existentes capturen fielmente los matices de la actuación de un actor en un personaje. Se requiere de animadores experimentados que pasen largas horas editando y retocando los resultados para obtener una animación verdaderamente realista.

Con MetaHuman Animator, se puede obtener una calidad de animación facial similar a la que exigen los desarrolladores de juegos triple A y los productores de Hollywood, y esta herramienta será accesible incluso para los estudios independientes y aficionados. Con un iPhone y un trípode estándar, se pueden crear animaciones creíbles para los personajes de MetaHuman y conectarse emocionalmente con el público.

La función también funciona con cualquier cámara de montaje frontal vertical estéreo de uso profesional, lo que mejora la calidad de los resultados. Además, si se tiene un sistema de captura de movimiento, el uso de códigos de tiempo de MetaHuman Animator permite alinear la animación de movimientos faciales con la captura de movimientos del cuerpo y con el audio para reproducir la actuación completa de un personaje. Incluso se puede utilizar el audio para crear animaciones convincentes de los movimientos de la lengua.

El proceso de creación de una MetaHuman Identity del actor comienza para asegurarse de que el sistema entienda la anatomía única del rostro del actor y cómo debe trasladarse a la del personaje objetivo. MetaHuman Animator utiliza esta identidad para interpretar la actuación realizando un seguimiento y solucionando las posiciones del rig facial de MetaHuman. Cada expresión, por sutil que sea, queda recreada de forma precisa en el personaje objetivo de MetaHuman, independientemente de las diferencias que haya entre las facciones del actor y las del MetaHuman.

Otra ventaja de esta función es que los datos de animación son limpios y las curvas de control son semánticamente correctas, lo que facilita posibles ajustes posteriores. Dado que se utiliza una MetaHuman Identity desde el principio, se puede estar seguro de que la animación creada seguirá funcionando si se realizan cambios más adelante en el personaje de MetaHuman, o incluso si se decide usarlo en otro.

MetaHuman Animator es una de las capacidades de procesamiento del complemento MetaHuman para Unreal Engine, cuya descarga es gratuita. Si se quiere utilizar un iPhone, se necesitará la aplicación Live Link Face para iOS, que también es gratuita y se actualizará con algunos modos de captura adicionales para permitir realizar este proceso.

Captura de rendimiento usando iPhone

MetaHuman Animator es una herramienta muy útil y práctica para los creadores de contenido que buscan mejorar la calidad de sus personajes de MetaHuman. Con esta nueva función, se puede lograr una animación facial de alta fidelidad en los personajes de MetaHuman de manera accesible y sin la necesidad de contar con conocimientos especializados o de invertir mucho tiempo en el proceso de captura de movimiento y animación. MetaHuman Animator simplifica significativamente el proceso de capturar las actuaciones de un actor y transferirlas a los personajes de MetaHuman, lo que lo hace más accesible tanto para estudios independientes como para aficionados.

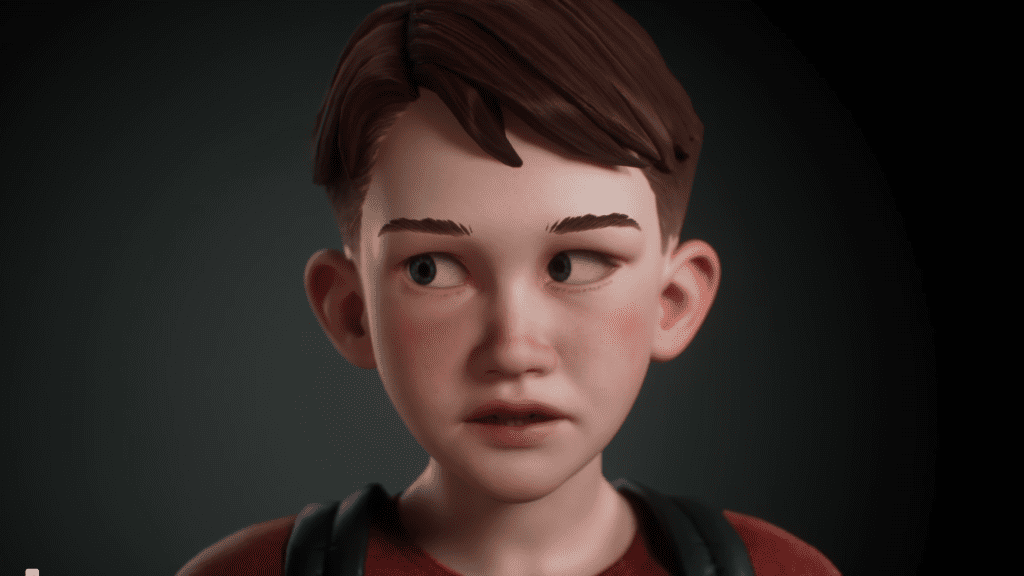

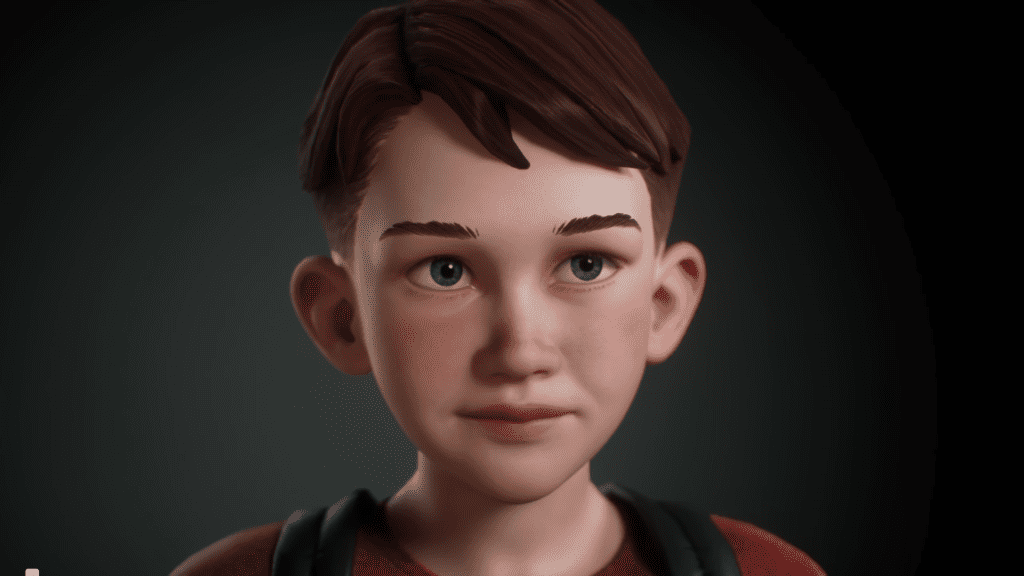

Una demostración con el próximo juego de Ninja Theory, Senua’s Saga: Hell Blade 2

Fuente: Unreal Engine

Editor y diseñador de Techno Ahora.